Công nghệ Al phát triển là một trong những bước tiến vượt bậc của con người. Trí tuệ nhân tạo kết hợp cùng bộ óc của con người đã mang lại nhiều phát minh mới giúp ích cho cuộc sống con người. Một trong số đó là Deepfakes. Video Deepfakes được tạo ra khiến cho một người có khả năng nhìn được những việc họ chưa từng làm trong thực tế. Tuy nhiên gần đây, rất nhiều hệ lụy từ việc sử dụng Deepfakes đã khiến cho người ta thực sự lo ngại rằng, liệu video này có nguy hiểm đến cuộc sống của con người hay không. Hãy cùng chúng tôi tìm hiểu xem thực sự Deepfakes là gì và có ảnh hưởng như thế nào nhé.

Deepfake là gì?

Bạn đã từng thấy Barack Obama gọi Donald Trump là “đồ nhảm nhí ”. Hay Mark Zuckerberg khoe khoang về việc có “ toàn quyền kiểm soát hàng tỷ dữ liệu bị đánh cắp của mọi người ”. Hoặc chứng kiến lời xin lỗi xúc động của Jon Snow vì cái kết ảm đạm của Game of Thrones? Câu trả lời của thế kỷ 21 chính là công nghệ deepfake. Vậy deepfake được tạo ra như thế nào?

Deepfakes ra đời vào năm 2017 khi một người dùng Reddit đăng clip khiêu dâm được kiểm duyệt lên web. Các video đã hoán đổi khuôn mặt của những người nổi tiếng – Gal Gadot, Taylor Swift, Scarlett Johansson và những người khác – thành những người biểu diễn khiêu dâm.

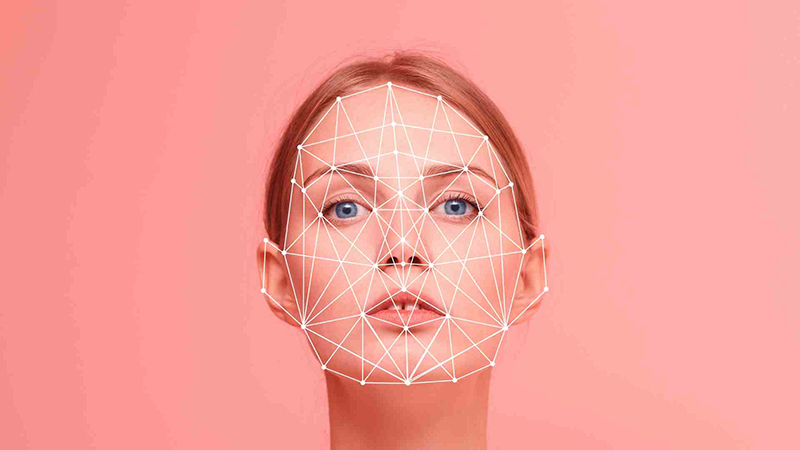

Cần một vài bước để tạo một video hoán đổi khuôn mặt. Đầu tiên, bạn chạy hàng nghìn bức ảnh chụp khuôn mặt của hai người thông qua một thuật toán AI. Đó được gọi là bộ mã hóa. Bộ mã hóa tìm và học các điểm tương đồng giữa hai khuôn mặt. Sau đó giảm xuống các đặc điểm chung được chia sẻ của chúng, nén hình ảnh trong quá trình này. Thuật toán AI thứ hai được gọi là bộ giải mã sau đó được dạy để khôi phục các khuôn mặt từ các hình ảnh đã nén. Vì khuôn mặt khác nhau, bạn tạo một bộ giải mã để khôi phục khuôn mặt của người đầu tiên. Và một bộ giải mã khác để khôi phục khuôn mặt của người thứ hai.

Làm thế nào để tạo ra Deepfakes

Năm ngoái, một ứng dụng có tên là Reface đã được phát hành cho các thiết bị iOS và Android. Người dùng có thể chụp ảnh tự sướng và chèn khuôn mặt của họ vào video, ảnh, GIF và meme. Những hình ảnh này có thể được chia sẻ bằng một lần nhấn. Ứng dụng tự quảng cáo bằng cách sử dụng dòng “Hãy là bất kỳ ai”. Nhưng nguy hiểm hơn nữa là một ứng dụng có tên Avatarify. Ứng dụng này cho phép người dùng định hướng chuyển động của khuôn mặt một người trên ảnh.

Điều này được thực hiện bằng cách chọn bất kỳ ảnh nào và với camera selfie trên điện thoại. Người dùng có thể kiểm soát biểu cảm, chuyển động của cá nhân có hình ảnh đang được sử dụng. Ứng dụng chỉ có sẵn cho iOS và đã được cài đặt hơn 6 triệu lần kể từ tháng 2/2021.

Giáo sư Anjana Susarla của Đại học bang Michigan nói: “Tất cả đều rất dễ thương khi chúng tôi làm điều này với ảnh của ông nội. Nhưng bạn có thể chụp ảnh của bất kỳ ai từ phương tiện truyền thông xã hội và tạo ra những hình ảnh chế tác về họ. Đó là điều đáng quan tâm”. Nhưng không phải tất cả các ứng dụng điện thoại thông minh này đều đe dọa như vậy. Wombo, có sẵn cho cả iOS và Android, tạo video hát nhép. Người dùng chọn ảnh và bài hát và ứng dụng thực hiện phần còn lại.

Giám đốc điều hành của Wombo, Ben-Zion Benkhin, nói rằng với ứng dụng của mình, “Bạn không thể chọn thứ gì đó quá khó chịu hoặc có thể bị hiểu sai”. Trong khi đó, ứng dụng phả hệ MyHeritage sẽ chụp ảnh người thân đã khuất và đưa họ sống lại. Được gọi là “Deep Nostalgia”, trang web này đã khiến hơn 65 triệu người “sống lại” trong 4 tuần qua.

Tại sao Deepfakes lại nguy hiểm?

Thực tế rằng có hơn 30 quốc gia tích cực tham gia vào chiến tranh mạng bất cứ lúc nào. Mối quan tâm hàng đầu với những trò lừa đảo có thể là những thứ như trang web Deepnudes. Đó là nơi khuôn mặt của người nổi tiếng và khuôn mặt của phụ nữ bình thường có thể bị ghép lên ảnh hoặc video khiêu dâm.

Người sáng lập của Deepnudes cuối cùng đã hủy bỏ việc ra mắt trang web. Vì họ lo ngại “xác suất người dùng sai mục đích là quá cao”.

Nhiều nội dung khiêu dâm. Công ty AI Deeptrace đã tìm thấy 15.000 video deepfake trực tuyến vào tháng 9 năm 2019. Con số này tăng gần gấp đôi trong vòng 9 tháng. Một con số đáng kinh ngạc 96% là phim khiêu dâm được deepfake từ những người nổi tiếng nữ. Khi các kỹ thuật mới cho phép những người không có kinh nghiệm tạo ra những bức ảnh fake bằng một số ảnh real, các video giả mạo có khả năng lan rộng ra ngoài thế giới. Như Danielle Citron, một giáo sư luật tại Đại học Boston, đã nói: “Công nghệ Deepfake đang được vũ khí hóa để chống lại phụ nữ”. Ngoài nội dung khiêu dâm ra, còn có rất nhiều nội dung giả mạo, châm biếm và đùa giỡn.

Deepfakes có luôn độc hại không?

Không hoàn toàn là độc hại. Một số là giải trí, tuy nhiên một số thì hữu ích. Kỹ thuật nhân bản giọng nói có thể khôi phục giọng nói của con người khi họ mất đi. Video Deepfake có thể làm sống động các phòng trưng bày và bảo tàng. Ở Florida, bảo tàng Dali có một bức ảnh sâu về họa sĩ siêu thực, người giới thiệu nghệ thuật của mình và chụp ảnh selfie với du khách. Đối với ngành giải trí, công nghệ có thể được sử dụng để cải thiện việc lồng tiếng cho phim cần sub. Và gây tranh cãi hơn là hồi sinh các diễn viên đã chết. Ví dụ, James Dean quá cố là do đóng vai chính trong Finding Jack, một bộ phim chiến tranh Việt Nam.

Để lại một phản hồi